Công nghệ đem lại nhiều tiện ích cho con người nhưng cũng tạo ra không ít mối hiểm họa nếu không được sử dụng đúng cách. Mới đây, một ứng dụng "độc hại" đã được phát hiện là có khả năng sử dụng trí tuệ nhân tạo (AI) để chuyển bất cứ ảnh chụp nào của phụ nữ thành ảnh khỏa thân.

Phần mềm này tên là DeepNude và đây là ví dụ về mới nhất về việc deepfake (công nghệ ghép khuôn mặt vào video bằng cách ứng dụng trí tuệ nhân tạo) được sử dụng vào mục đích xấu.

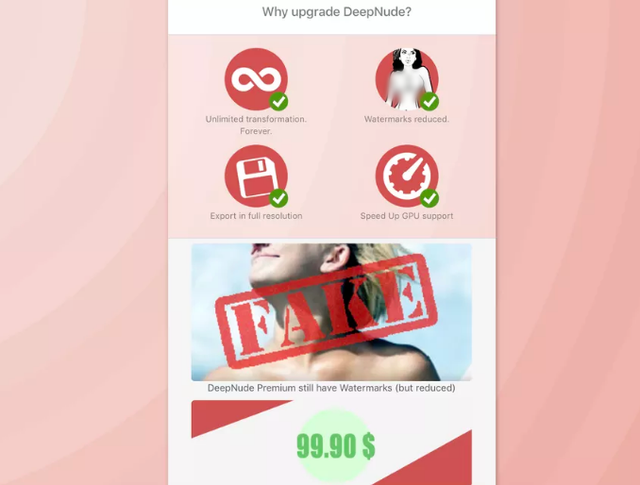

Samantha Cole của Motherboard là người đầu tiên phát hiện ra DeepNude, hiện miễn phí tải về trên hệ điều hành Windows, bên cạnh đó là phiên bản cao cấp cho hình ảnh đầu ra có độ phân giải tốt hơn với giá 99,9 USD.

DeepNude phiên bản cao cấp có giá 99,9 USD

Cả hai phiên bản đều tạo ra những bức ảnh có đóng dấu (watermark) làm dấu hiệu cho biết đó là ảnh giả. Nhưng theo Motherboard, các watermark này đều có thể xóa đi một cách dễ dàng.

DeepNude hoạt động tốt nhất với hình ảnh có độ phân giải cao hoặc đối tượng trong ảnh ăn mặc hở hang. Tuy nhiên, ảnh khỏa thân tạo ra vẫn có chất lượng thấp với phần da bị làm mờ và nhiều lỗi pixel. Vì vậy, nếu xem xét kỹ, chúng ta vẫn có thể dễ dàng nhận ra đây là ảnh giả mạo.

Mặc dù ngay cả khi ảnh đầu ra có chất lượng thấp thì ảnh khỏa thân giả mạo vẫn dễ gây nhầm lẫn và có thể gây ra thiệt hại không nhỏ cho nạn nhân. Thời gian gần đây xuất hiện nhiều tranh cãi về việc dùng deepfake làm sai lệch thông tin chính trị nhưng với sự ra đời của DeepNude, chúng ta lại có một mối lo mới là nguy cơ lạm dụng tình dục hình ảnh phụ nữ.

Trước đó, vào tháng 12/2017, một người dùng đã sử dụng deep learning để ghép khuôn mặt của hàng loạt ngôi sao nữ vào "cảnh nóng" trong phim người lớn rồi tung lên Reddit. Tất nhiên, chúng đều là giả nhưng những hình ảnh mà anh ta đưa lên đã ảnh hưởng nghiêm trọng đến danh dự của nạn nhân.

Một báo cáo gần đây của HuffPost đã nhấn mạnh việc trở thành nạn nhân của loại deepfake này có thể "kết thúc" cuộc đời của người đó. Ảnh nude giả có thể được dùng để quấy rối, trả thù hay đe dọa phụ nữ.

Thậm chí còn có những diễn đàn nơi cánh mày râu trả tiền cho chuyên gia để tạo ảnh khỏa thân của đồng nghiệp, bạn bè hay thành viên gia đình. Và công cụ miễn phí như DeepNude lại càng giúp họ dễ dàng thực hiện ý đồ xấu của mình hơn.

DeepFake đang tạo ra nhiều mối nguy hại tiềm tàng cho xã hội.

Đáng chú ý, DeepNude không có khả năng tạo ra ảnh nude của nam giới. Theo Motherboard, nếu người dùng cung cấp hình ảnh của một người đàn ông, phần mềm sẽ thêm bộ phận sinh dục nữ vào bức ảnh.

Người tạo ra DeepNude tự nhận mình là "Alberto". Anh cho biết cảm hứng tạo ra ứng dụng đến từ những cuốn truyện tranh từ ngày xưa với công nghệ X-quang có thể nhìn xuyên quần áo. Người này nói rằng mình là người đam mê công nghệ và bị thúc đẩy bởi sự tò mò về AI.

Alberto đã xem xét khả năng gây hại của DeepNude nhưng cho rằng đây không phải vấn đề quá nghiêm trọng. Anh nói: "Tôi luôn tự nhủ công nghệ này hoàn toàn nằm trong tầm với của mọi người. Do đó, nếu tôi không tạo ra DeepNude thì người khác cũng sẽ sớm tạo ra nó trong thời gian tới. Đối với tôi, phần mềm này chỉ mang tính chất giải trí và tôi không có mục đích khiến nó trở nên phổ biến".

Người dùng có thể tải DeepNude miễn phí hoặc thử online.

Ngoài ra, Alberto cũng lo lắng về vấn đề pháp lý. Thỏa thuận cấp phép của DeepNude nêu rõ: "Mọi hình ảnh tạo ra đều là giả và phần mềm này chỉ mang tính giải trí".

Theo luật sư, việc tạo ra ảnh nude bằng AI có thể cấu thành tội phỉ báng, đặc biệt là khi nạn nân là trẻ vị thành niên. Hiện chính phủ các nước trên khắp thế giới đang bắt đầu xem xét tác hại tiềm ẩn do deepfake gây ra. Trong tương lai, những ứng dụng như DeepNude gần như chắc chắn sẽ ngày càng phổ biến và tạo ra sản phẩm chân thực hơn, gây ra nhiều nguy cơ cho toàn xã hội.

Không có nhận xét nào:

Đăng nhận xét